1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

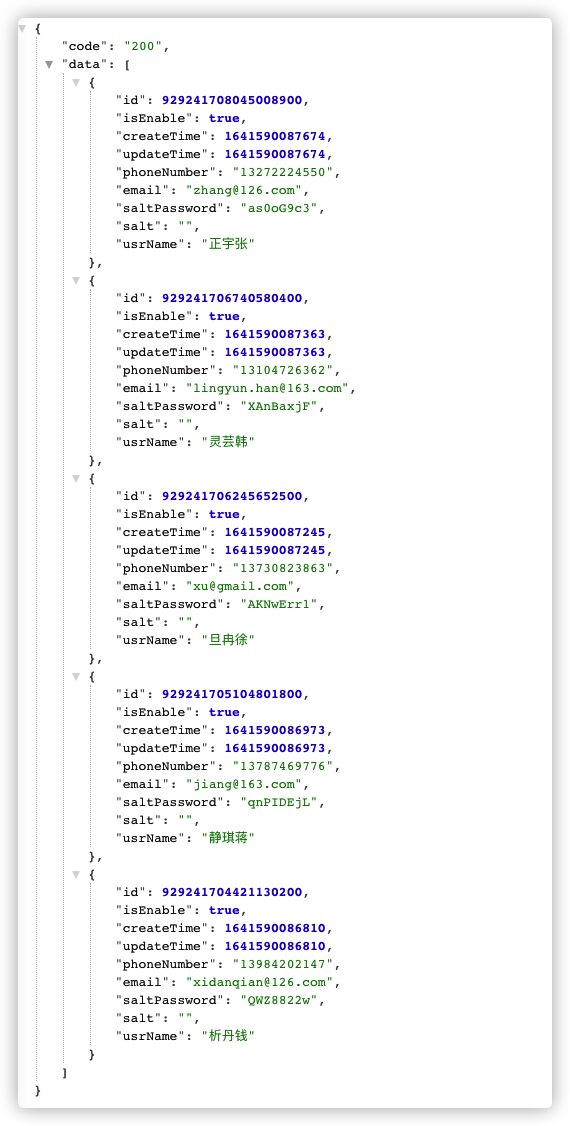

| [XNIO-1 task-1] [BaseJdbcLogger.java : 137] ==> Preparing: SELECT id,is_enable,create_time,update_time,phone_number,email,salt_password,salt,usr_name FROM account

[XNIO-1 task-1] [BaseJdbcLogger.java : 137] ==> Parameters:

[XNIO-1 task-1] [BaseJdbcLogger.java : 137] <== Total: 2

[XNIO-1 task-1] [MybatisInterceptor.java : 80] [{"id":"1","selectType":"SIMPLE","table":"account","type":"ALL","rows":"2","filtered":"100.0"}]

[XNIO-1 task-1] [MybatisInterceptor.java : 82] SQL RunTime 15 ms

[XNIO-1 task-1] [BaseJdbcLogger.java : 137] ==> Preparing: INSERT INTO account ( is_enable, create_time, update_time, phone_number, email, salt_password, usr_name ) VALUES ( ?, ?, ?, ?, ?, ?, ? )

[XNIO-1 task-1] [BaseJdbcLogger.java : 137] ==> Parameters: true(Boolean), 1643953933094(Long), 1643953933094(Long), 13611707472(String), chu@gmail.com(String), Xe8mbdpS(String), 析丹楚(String)

[XNIO-1 task-1] [BaseJdbcLogger.java : 137] <== Updates: 1

[XNIO-1 task-1] [MybatisInterceptor.java : 54] EXPLAIN

SELECT

id,

is_enable,

create_time,

update_time,

phone_number,

email,

salt_password,

salt,

usr_name

FROM

account

[XNIO-1 task-1] [BaseJdbcLogger.java : 137] ==> Preparing: SELECT id,is_enable,create_time,update_time,phone_number,email,salt_password,salt,usr_name FROM account

[XNIO-1 task-1] [BaseJdbcLogger.java : 137] ==> Parameters:

[XNIO-1 task-1] [BaseJdbcLogger.java : 137] <== Total: 3

[XNIO-1 task-1] [MybatisInterceptor.java : 80] [{"id":"1","selectType":"SIMPLE","table":"account","type":"ALL","rows":"3","filtered":"100.0"}]

[XNIO-1 task-1] [MybatisInterceptor.java : 82] SQL RunTime 8 ms

|